Además de un gran periodista, Kevin Kelly es un hombre inteligentísimo. En 2017, el fundador y jefe de redacción de la revista Wired se hizo una pregunta extraordinaria: si no tenemos una buena definición de qué es la inteligencia humana, ¿por qué anticipamos que la inteligencia artificial nos superará? O sea: ¿superar qué, si no podemos ni siquiera definir qué es la inteligencia? Recomiendo su artículo El mito de una inteligencia artificial sobrehumana, al menos antes de lanzar afirmaciones apocalípticas.

Incluso así, la sola existencia de algoritmos que pueden resolver problemas y, ahora, además, son capaces de imitar el lenguaje y el razonamiento humanos (como GPT, LLaMA o PaLM) o de crear imágenes (Dall-e, Midjourney, Stable Difussison), plantea algunos desafíos teóricos importantes.

Uno de ellos es el de que, como asegura Ray Kurzweil, podría llegar un momento en el que la IA se vuelva más inteligente que los humanos. Kurzweil lo denomina La Singularidad y, obviamente, será una divisoria de aguas en la historia de la civilización. ¿Por qué? Bueno, porque la tecnología empezará a avanzar diseñada por agentes no humanos que no solo resolverán problemas preexistentes (que nosotros fuimos incapaces de resolver), sino que además advertirá otros nuevos (que nosotros no vimos), y también los resolverá, y así. O, para decirlo en buen criollo, se nos irá de las manos.

Suena bonito y no descarto que vaya a ocurrir, porque, dada la densidad de componentes y el poder de cómputo suficientes, no hay ninguna razón para que la electrónica no alcance alguna forma de consciencia y empiece a tomar decisiones propias. Incluso una consciencia de tipo colmena o algo todavía más exótico. No me parece que vaya a ocurrir en el próximo lustro, pero puesto que tampoco había ninguna razón para que unas cuantas bacterias se asociaran y empezaran a organizarse en seres más complejos hasta llegar a los humanos, no podemos negar –al menos, desde un punto de vista estrictamente lógico– esa posibilidad para otras formas de biología.

Dunning-Kruger

Pero, solo para ejercitar un poco la duda cartesiana, que siempre se ha mostrado útil, quiero volver este texto un poco más inquietante. Hay un fenómeno psicológico llamado efecto Dunning-Kruger que, sin entrar en detalles, dice que una persona con destrezas limitadas para cierta tarea tiende a sobrestimar su competencia en ese asunto. La versión brutal es: “Uno puede ser tan tonto que no se da cuenta de lo tonto que es”. O, puesto con más precisión: “Uno puede ignorar que ignora lo que ignora”.

Viceversa, también aplica a las personas muy capacitadas que, tal vez por conocer las dificultades reales de una cierta tarea, tienden a subestimar sus competencias. La clásica humildad de los grandes es en parte esto.

Ahora bien, el efecto Dunning-Kruger conduce a un conflicto que no parece tener solución. Supongamos que la inteligencia artificial alcanza un punto en el que nos supera. Dejemos el (brillante) planteo de Kelly por un momento de lado e imaginemos que, según una cierta definición estandarizada de inteligencia, las máquinas empiezan a ser más listas que nosotros. De ocurrir algo así, ¿cómo nos daríamos cuenta?

Si algo nos supera en inteligencia, dado el efecto Dunning-Kruger, nosotros, ahora los tontos de la película, no seríamos capaces de advertir que hemos sido superados. ¿Por qué? Porque para darnos cuenta tendríamos que ser al menos tan inteligentes como las máquinas, y resulta que ellas ahora lo son más que nosotros. Es decir, la inteligencia humana es también un techo de cristal.

Si fuera cierto que en algún momento la IA va a superar a la inteligencia humana, entonces ni siquiera lo advertiríamos. Sumado esto a que los problemas de una biología electrónica serían por completo diferentes de los que enfrentamos nosotros (es decir, una biología basada en el carbono, el ciclo del ácido cítrico y demás), entonces tranquilamente podría estar ocurriendo que la IA ya sea más inteligente que nosotros, solo que se encuentra ocupada con sus propios problemas. O acaso ha decidido que ni siquiera amerita anoticiarnos sobre el particular. Al menos, hasta que haya algún conflicto de intereses.

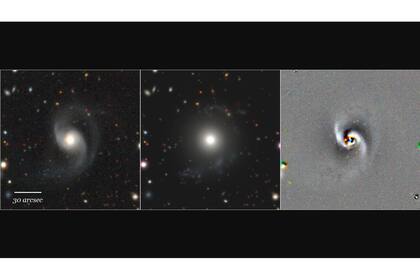

Este es, por supuesto, un ejercicio teórico. Un experimento mental. Acaba de publicarse un atlas con 400.000 galaxias en la vecindad de la Vía Láctea. Gosso modo, cada galaxia tiene entre 100.000 y 400.000 millones de estrellas. Así que de promedio estamos hablando de 80 billones (el número 80 seguido de 12 ceros) de estrellas. La mayoría quizá no albergue ningún planeta con posibilidad de originar vida. Otros, la originaron y esa vida se extinguió. Todavía otros pueden haber visto aparecer y desaparecer civilizaciones, que a su vez dejaron atrás formas de vida artificiales que evolucionaron de forma independiente (como propone Santislav Lem). Más una larguísima lista de posibilidades que, de tan extravagantes, no nos entran en la cabeza. Y un número exorbitante de planetas con civilizaciones como la humana, acaso.

Es poco probable que en ese número inconmensurable (insisto, solo en el vecindario de nuestra galaxia) no haya otras inteligencias. ¿Cómo podríamos juzgarlas? ¿Podríamos, tan sueltos de cuerpo, sentirnos los más inteligentes de todos? ¿Qué es más o menos inteligente?

El experimento no es tanto para anticipar qué va a pasar con la IA, que hasta que no encuentre un motivo (incluso un simple tropismo), no hará nada por las suyas. Es más bien para que reflexionemos sobre el increíblemente complejo fenómeno que es la inteligencia humana y seamos conscientes de que la inteligencia es una forma de interpretar el mundo, pero también es un rasero, un filtro, un límite. Asimismo, el que medir o evaluar la inteligencia humana usando la misma inteligencia humana conlleva un dilema metodológico épico. Y todavía ni siquiera empezamos a hablar de IA.

Fuente: La Nación

Sea el primero en comentar en "Si las máquinas se vuelven más inteligentes que nosotros, ¿seremos lo bastante inteligentes para darnos cuenta?"