Durante 2020 y 2021 miles, millones de personas adoptaron herramientas digitales. Algunos lo llamaron transformación digital. Pero algunos datos permiten dudar de ese mecanismo aparentemente voluntario. El pico máximo de las búsquedas de palabras como “Mercado Pago”, o “banco online” se dieron al inicio de la pandemia. Nunca se habían buscado tanto como en ese momento. Por eso, más que un proceso virtuoso, amable, voluntario, lo que sucedió en esa época se pareció más a un exilio analógico: un proceso inverso, forzado, obligatorio, del que no hubo vuelta atrás. En ese camino hubo muchos aprendizajes, claro. Aunque muchos fueron a costa de la seguridad. Los datos son evidentes: nunca se vieron tantos delitos digitales como desde esa época.

En ese interín, los delincuentes aprovecharon que hoy interactuamos más con cuentas digitales que con personas. Aunque parezcan lo mismo, no lo son. Aunque esas cuentas correspondan a ciertas personas, a veces pueden no coincidir. Como pasó en las estafas de WhatsApp, cuando alguien perdía su cuenta y entonces ya no hablábamos con esa persona sino con alguien que simulaba serlo, que aprovechaba para hacerle perder dinero a la víctima. O cuando alguien perdía su Instagram. O cuando más a nivel corporativo, sucedía un BEC (Business Email Compromised), y alguien se apoderaba de la identidad de correo electrónico de un CEO (o una posición similar), un gerente o un proveedor de servicios para engañar al receptor con un mensaje urgente o un cambio de cuenta bancaria (que controlan los delincuentes) para hacerle perder dinero a empresas y, a veces, hasta empleos a empleados.

Había hasta aquí un método infalible para evitar esas caídas. Todas estas cuestiones podían destrabarse o caerse como un castillo de naipes, con una técnica muy vieja y actual: un llamado telefónico a esa persona con una pregunta tan simple como: “¿vos me estás pidiendo plata?”, que compruebe que alguien había perdido su cuenta, o que había cambios bancarios en el proveedor, o que el jefe efectivamente estaba pidiendo algo urgente. Escuchar la voz, por ejemplo, preguntarle si es así, y listo. Todo se desbarataba. O eso creíamos. Pero eso cambió. O tiene ahora un nuevo nivel de complejidad.

Messi no habla inglés, pero una inteligencia artificial genera el audio y adapta el movimiento de su voz

El problema es que en el medio irrumpió la inteligencia artificial y ahora los delincuentes ya no se conforman únicamente con apoderarse de las cuentas o las identidades digitales. Ahora van por características biométricas.

A principios de 2020, según cuenta Forbes, el gerente de una sucursal de una empresa japonesa en Hong Kong recibió una llamada de un hombre cuya voz reconoció: era el director de su empresa matriz. El director tenía buenas noticias: la empresa estaba a punto de realizar una adquisición, por lo que necesitaba autorizar algunas transferencias por valor de 35 millones de dólares. El gerente, que escuchó la voz de su superior, creyó que todo parecía legítimo, y comenzó a realizar las transferencias. Todo era falso.

En China se reportaron varios casos con una misma modalidad: un estafador utilizó la inteligencia artificial para hacerse pasar por un amigo de confianza en una videollamada y convencerlo de que le entregara millones de yuanes. La más conocida le sucedió a un ciudadano de apellido Guo, quien recibió una videollamada de una persona que era exactamente igual a su amigo cercano. Pero la persona que llamaba era en realidad un estafador que utilizaba tecnología inteligente de inteligencia artificial para cambiar su rostro y su voz, según distintos artículos publicados en la ciudad meridional de Fuzhou.

Son apenas ejemplos incipientes de qué tan difícil podrá ser, mediante medios digitales, determinar que una persona es realmente es esa persona.

Nos pasa a nosotros, les pasa a las máquinas

“El banco pensó que me estaba hablando a mí; la voz generada por IA ciertamente sonaba igual”, cuenta el periodista Joseph Cox, del medio VICE. Cox trataba de ingresar a su cuenta bancaria del Lloyds Bank en el Reino Unido mediante una llamada telefónica. El sistema exige reconocer la voz para poder consultar saldos o incluso utilizar ciertos servicios bancarios. Se trata de una modalidad que aún existe en Europa, en algunos países de Latinoamérica (como Brasil) y en Estados Unidos, pero no en Argentina. El periodista tuvo una idea: utilizar una inteligencia artificial que imita su forma de hablar.

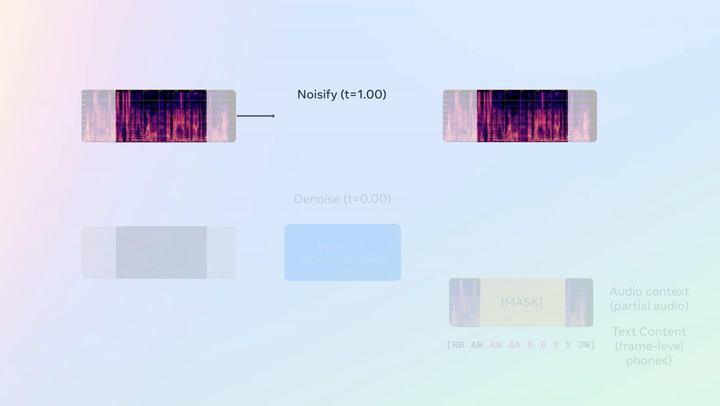

Voicebox es un sintetizador que puede replicar cualquier voz con 3 segundos de audio

“El miércoles, llamé a la línea de servicio automatizado de mi banco. Para empezar, el banco me pidió que dijera con mis propias palabras por qué estaba llamando. En lugar de hablar en voz alta, hice clic en un archivo en mi computadora portátil cercana para reproducir un clip de sonido: “verifique mi saldo”, dijo mi voz. Pero esta no era en realidad mi voz. Era un clon sintético que había hecho usando tecnología de inteligencia artificial fácilmente disponible”, explica.

“Luego me pidió que ingresara o dijera mi fecha de nacimiento como la primera pieza de autenticación. Después de escribir eso, el banco dijo “por favor diga, ‘mi voz es mi contraseña’”, relata en un extenso artículo. “Nuevamente, reproduje un archivo de sonido desde mi computadora. El sistema de seguridad del banco tardó unos segundos en autenticar la voz. Y le dio el okey. Con eso, pudo ingresar.

Tecnología ya disponible para engañar

Tom Graham es el CEO de una empresa que se llama Metaphysic, una compañía que se hizo popular, entre otras cosas, por haber creado la cuenta de TikTok del falso Tom Cruise, e incluso por proponer la protección legal de las creaciones artificiales en favor de los artistas. Está en eso. Pero, más allá de los dilemas que intenta resolver, demostró en una charla Ted cómo es posible cambiar un rostro en tiempo real, y al mismo tiempo hacer lo propio con la voz. IA y tiempo real. En vivo. Solo hay que empezar a entrenarla.

La Inteligencia Artificial avanza a pasos agigantados y cada vez imita mejor lo humano. Y en términos de ciberseguridad aparecen varios interrogantes. Siguiendo el caso del banco del Reino Unido, pero también los accesos que dependen de rostros huellas y demás, ¿cómo harán los dispositivos o los sistemas para que un rostro falso, una voz clonada, una cara construida no sirva para autenticarse?

Sobre esto, el licenciado Cristian Borghello, especialista en Ciberseguridad y Director de Segu-Info, señala un punto crucial del problema de autenticación biométrico en estos tiempos. “Si yo tengo una cámara o mi aplicación definitivamente es mala lo que estoy haciendo es que el nivel de seguridad no sirva para nada, y por lo tanto estoy ofreciendo una falsa sensación de seguridad”, explica. Y hace un análisis de lo que viene, pesimista sobre los sistemas de autenticación biométricos: “el tema es hasta cuándo vamos a poder seguir mejorando los dispositivos de hardware y las aplicaciones para que el proceso de autenticación sea lo más exacto posible y efectivamente poder verificar fehacientemente que la persona es quien dice ser. Porque a la vez el atacante mejora continuamente el proceso de inteligencia artificial para simular voz o simular la cara de una persona, y eso hará que tarde o temprano el proceso de detección biométrico tenga límites y no vayas a ver diferenciar entre una voz y una cara de un ser humano real y algo hecho por deepfake. Por eso el proceso de biometría va a tener una época de caducidad. El tema es ver cómo se va a reemplazar los sistemas biométricos actuales”.https://www.youtube.com/embed/FcfUE7vU_oE?feature=oembed

Federico Kirschbaum, especialista en ciberseguridad y CEO de Faraday, considera que “la percepción de la biometría no tiene que ver con seguridad, sino con conveniencia. Si alguien te roba tu huella o tu rostro, no la podés cambiar. Pero es más cómoda que poner seis dígitos para desbloquear algo”, señala. Y agrega: “Lo que cambió con la IA generativa es que se convirtió en muy económico generar información falsa. Hace 5 u 8 años era muy caro, y ahora es muy barato. Por lo cual, todos los mecanismos que se crearon alrededor de la biométrico ya se volvieron obsoletos”, coincide.

¿Y ahora qué?

En cambio, señalan ambos, el futuro está más relacionado con el concepto paswordless (sin contraseña). “Lo que se hace es reemplazar el nombre de usuario y contraseña típico de toda la vida con un dispositivo que puede ser de hardware aparte -puede ser un teléfono de los últimos años- en donde se utiliza una clave privada que se almacena en el dispositivo, de forma tal que cuando el usuario quiera loguearse en Google, en vez de pedirme el usuario y la contraseña que me pide siempre, me pide acceso al dispositivo; como yo tengo el dispositivo conmigo, le digo que acceda al dispositivo, y Google habla directamente con el dispositivo y saca la clave privada que tiene ahí adentro y a partir de ahí se autentica”, explica Borghello.

Y agrega: “Eso tiene un montón de garantías adicionales; primero, el usuario no tiene que recordar una contraseña ni la tiene que ingresar nunca; segundo no le pueden robar la contraseña al usuario, porque la contraseña privada está almacenada dentro del dispositivo, y tercero tengo un doble factor de autenticación implícito porque la contraseña está dentro del dispositivo, por lo tanto yo tengo que tener el dispositivo conmigo. Es algo que ´yo sé´, la clave que está almacenada, y algo que ´yo tengo´. La contra que podría llegar a tener eso es que si a mí me roban el dispositivo o lo pierdo, es un problema, pero ahí hay métodos alternativos de recuperación. Pero desde el punto de vista de seguridad eleva mucho la vara, porque no estamos dependiendo de una clave del usuario y tampoco estamos hablando de un componente biométrico”, explica Borghello.

Pero falta la parte humana

Si bien aparecen desafíos en el horizonte -el entrenamiento y aprendizaje de los usuarios de estas nuevas tecnologías-, parece ser una alternativa más sustentable que lo biométrico. Pero a la vez, falta la otra parte, el verificador humano, que dependerá de otra cuestión: la concientización. Según el World Economic Forum, el 95% de los problemas de ciberseguridad tienen su origen en errores humanos

Por eso, si bien los sistemas parecen tener alternativas, queda aún por resolver el dilema humano. Nosotros, en esta nueva era del exilio analógico: ¿cómo haremos para darnos cuenta, a través de nuestros sentidos, que alguien es (pantalla de por medio) efectivamente quien dice ser?

Fuente: La Nación

Sea el primero en comentar en "Cómo sabremos si alguien es quien dice ser en la era del deepfake en tiempo real"